Cum să faci textul corect al roboților pentru wordpress. Adăugați cu Yoast SEO

Salutare tuturor! Astăzi aș vrea să vă povestesc despre fișierul robots.txt. Da, s-au scris multe despre asta pe internet, dar, sincer să fiu, de foarte mult timp eu însumi nu am putut înțelege cum să creez robots.txt-ul corect. Am ajuns să fac unul și este pe toate blogurile mele. Nu observ nicio problemă, robots.txt funcționează bine.

Robots.txt pentru WordPress

De ce, de fapt, aveți nevoie de robots.txt? Răspunsul este în continuare același - . Adică, compilarea robots.txt este una dintre părțile optimizării pentru motoarele de căutare a unui site (apropo, foarte curând va exista o lecție care va fi dedicată întregii optimizări interne a unui site pe WordPress. Prin urmare, nu uitați să vă abonați la RSS pentru a nu pierde materiale interesante.).

Una dintre funcțiile acestui fișier este interdicția de indexare pagini de site inutile. De asemenea, stabilește adresa și precizează principalul lucru oglinda site-ului(site cu sau fără www).

Notă: pentru motoarele de căutare, același site cu www și fără www sunt site-uri complet diferite. Dar, realizând că conținutul acestor site-uri este același, motoarele de căutare le „lipesc” împreună. Prin urmare, este important să înregistrați oglinda principală a site-ului în robots.txt. Pentru a afla care este cel principal (cu www sau fără www), trebuie doar să introduceți adresa site-ului dvs. în browser, de exemplu, cu www, dacă sunteți redirecționat automat către același site fără www, atunci oglinda principală a site-ul tau este fara www. Sper ca am explicat corect.

Deci, aceasta prețuită, după părerea mea, robots.txt corect pentru WordPress Puteți vedea mai jos.

Robots.txt corect pentru WordPress

Agent utilizator: *

Nu permiteți: /cgi-bin

Nu permiteți: /wp-admin

Nu permiteți: /wp-includes

Nu permiteți: /wp-content/cache

Nu permiteți: /wp-content/themes

Disallow: /trackback

Nu permite: */trackback

Nu permiteți: */*/trackback

Nu permiteți: */*/feed/*/

Nu permiteți: */feed

Nu permite: /*?*

Nu permiteți: /tag

Agent utilizator: Yandex

Nu permiteți: /cgi-bin

Nu permiteți: /wp-admin

Nu permiteți: /wp-includes

Nu permiteți: /wp-content/plugins

Nu permiteți: /wp-content/cache

Nu permiteți: /wp-content/themes

Disallow: /trackback

Nu permite: */trackback

Nu permiteți: */*/trackback

Nu permiteți: */*/feed/*/

Nu permiteți: */feed

Nu permite: /*?*

Nu permiteți: /tag

Gazdă: site web

.gz

Harta site-ului: https://site/sitemap.xml

Trebuie să copiați tot ce este dat mai sus într-un document text cu extensia .txt, adică astfel încât numele fișierului să fie robots.txt. Puteți crea acest document text, de exemplu, utilizând programul. Doar nu uita, te rog schimba ultimele trei linii adresa la adresa site-ului dvs. web. Fișierul robots.txt ar trebui să fie localizat în rădăcina blogului, adică în același folder în care se află folderele wp-content, wp-admin etc.

Cei cărora le este prea lene să creeze acest fișier text, puteți pur și simplu descărca robots.txt și, de asemenea, corectați 3 rânduri acolo.

Aș dori să remarc că nu trebuie să vă suprasolicitați cu părțile tehnice care vor fi discutate mai jos. Le aduc pentru „cunoaștere”, ca să zic așa, o perspectivă generală, astfel încât să știe de ce este nevoie și de ce.

Deci linia:

User-agent

stabilește reguli pentru un anumit motor de căutare: de exemplu, „*” (asterisc) indică faptul că regulile sunt pentru toate motoarele de căutare și ceea ce este mai jos

Agent utilizator: Yandex

înseamnă că aceste reguli sunt doar pentru Yandex.

Nu permiteți

Aici „arunci” secțiuni care NU trebuie să fie indexate de motoarele de căutare. De exemplu, pe pagina https://site/tag/seo am un duplicat de articole (repetiție) cu articole obișnuite, iar duplicarea paginilor are un impact negativ asupra promovării motoarelor de căutare, prin urmare, este foarte de dorit ca aceste sectoare trebuie să fie închis de la indexare, ceea ce facem folosind această regulă:

Nu permiteți: /tag

Deci, în robots.txt dat mai sus, aproape toate secțiunile inutile ale unui site WordPress sunt închise de la indexare, adică lăsați totul așa cum este.

Gazdă

Aici am setat oglinda principală a site-ului, despre care am vorbit chiar mai sus.

Harta site-ului

În ultimele două rânduri, setăm adresa a până la două sitemap-uri create folosind .

Probleme posibile

Dar din cauza acestei linii din robots.txt, postările de pe site-ul meu nu au mai fost indexate:

Nu permite: /*?*

După cum puteți vedea, chiar această linie din robots.txt interzice indexarea articolelor, de care, desigur, nu avem nevoie deloc. Pentru a remedia acest lucru, trebuie doar să eliminați aceste 2 rânduri (în regulile pentru toate motoarele de căutare și pentru Yandex), iar robots.txt final corect pentru un site WordPress fără CNC va arăta astfel:

Agent utilizator: *

Nu permiteți: /cgi-bin

Nu permiteți: /wp-admin

Nu permiteți: /wp-includes

Nu permiteți: /wp-content/plugins

Nu permiteți: /wp-content/cache

Nu permiteți: /wp-content/themes

Disallow: /trackback

Nu permite: */trackback

Nu permiteți: */*/trackback

Nu permiteți: */*/feed/*/

Nu permiteți: */feed

Nu permiteți: /tag

Agent utilizator: Yandex

Nu permiteți: /cgi-bin

Nu permiteți: /wp-admin

Nu permiteți: /wp-includes

Nu permiteți: /wp-content/plugins

Nu permiteți: /wp-content/cache

Nu permiteți: /wp-content/themes

Disallow: /trackback

Nu permite: */trackback

Nu permiteți: */*/trackback

Nu permiteți: */*/feed/*/

Nu permiteți: */feed

Nu permiteți: /tag

Gazdă: site web

Harta site-ului: https://site/sitemap.xml

Pentru a verifica dacă am compilat corect fișierul robots.txt, vă recomand să utilizați serviciul Yandex Webmaster (ți-am spus cum să vă înregistrați în acest serviciu).

Accesați secțiunea Setări de indexare –> Analiză Robots.txt:

Deja acolo, faceți clic pe butonul „Încărcați robots.txt de pe site”, apoi faceți clic pe butonul „Verificați”:

Dacă vedeți ceva de genul următor mesaj, înseamnă că aveți robots.txt-ul corect pentru Yandex:

Pentru a vă asigura că site-ul dvs. se clasează bine în paginile cu rezultate ale motoarelor de căutare (SERPs), trebuie să faceți ca paginile dvs. cele mai importante să poată fi căutate și indexate de motoarele de căutare. Fișier bine structurat robots.txt va ajuta la direcționarea acelor roboți către paginile pe care doriți să le indexați (și să omiteți altele).

În acest articol vom acoperi următoarele întrebări:

- Ce este un fișier robots.txtși de ce este important

- Unde este robots.txt pentru WordPress

- Cum se creează un fișier robots.txt

- Ce reguli ar trebui să fie în dosar robots.txt pentru WordPress

- Cum se verifică un fișier robots.txtși trimite-l către Google Search Console.

Până la sfârșitul discuției noastre, veți avea tot ce aveți nevoie pentru a configura un fișier grozav robots.txt pentru site-ul dvs. WordPress. Să începem!

Ce este un fișier robots.txt pentru WordPress și de ce este nevoie

Când creați un site web nou, motoarele de căutare își vor trimite slujitorii (sau roboții) să se acceseze cu crawlere și să creeze o hartă a tuturor paginilor sale. În acest fel, ei vor ști ce pagini să afișeze ca rezultat atunci când cineva caută cuvinte cheie asemănătoare. La nivel de bază, este destul de simplu.

Problema este că site-urile web moderne conțin multe alte elemente în afară de pagini. WordPress vă permite să instalați pluginuri, de exemplu, care au adesea propriile directoare. Nu doriți să afișați acest lucru în SERP-uri deoarece nu se potrivesc cu conținutul.

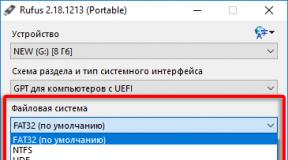

Odată conectat la site-ul dvs., accesați directorul public_html. Acum, tot ce trebuie să faceți este să încărcați fișierul robots.txt de la computer la server. Puteți face acest lucru fie făcând clic dreapta pe fișier în browserul dvs. FTP local, fie pur și simplu trăgând și plasând:

Va dura doar câteva secunde. După cum puteți vedea, această metodă nu este mai complicată decât utilizarea unui plugin.

Cum să verificați WordPress robots.txt și să îl trimiteți la Google Search Console

Acum că fișierul dvs. WordPress robots.txt a fost creat și încărcat pe site, îl puteți verifica pentru erori în Google Search Consoles. Search Console este un set de instrumente Google concepute pentru a vă ajuta să urmăriți modul în care conținutul dvs. apare în rezultatele căutării. Un astfel de instrument verifică robots.txt, îl puteți folosi accesând secțiunea din consolă Instrument de inspecție a fișierelor Robots.txt:

Aici veți găsi un câmp editor unde puteți adăuga codul pentru fișierul dvs. WordPress robots.txtși faceți clic pe Trimiteți în colțul din dreapta jos. Google Search Console vă va întreba dacă doriți să utilizați un cod nou sau să încărcați un fișier de pe site-ul dvs. Selectați opțiunea care spune Cereți Google să actualizeze pentru a publica manual:

Platforma va verifica acum fișierul pentru erori. Dacă se găsește o eroare, vi se vor afișa informații despre aceasta.

Ați văzut câteva exemple de fișiere robots.txt WordPress, iar acum ai și mai multe șanse să-ți creezi cel perfect!

Concluzie

Pentru a vă asigura că site-ul dvs. este prezentat în cel mai bun mod posibil de a căuta roboți, ar trebui să vă asigurați că conținutul necesar este deschis pentru aceștia. După cum am văzut, un fișier bine configurat robots.txt WordPress le va ajuta să le arate roboților cum să interacționeze cel mai bine cu site-ul dvs. Astfel, îi vor ajuta pe cei care caută conținut mai relevant și mai util.

Mai aveți întrebări despre cum să editați? robots.txtîn WordPress? Anunțați-ne în secțiunea de comentarii de mai jos!

De la autor: Unul dintre fișierele pe care le folosesc motoarele de căutare atunci când vă indexează site-ul este fișierul robots.txt. Nu este greu de înțeles din numele fișierului că este folosit pentru roboți. Într-adevăr, acest fișier vă permite să spuneți robotului de căutare ce poate fi indexat pe site-ul dvs. și ce nu doriți să vedeți în indexul de căutare. Deci, să vedem cum să configurați roboți txt pentru un site WordPress.

Există multe articole pe acest subiect pe internet. În aproape fiecare dintre aceste articole puteți găsi propria dvs. versiune a fișierului robots txt, pe care o puteți lua și utiliza practic fără modificări pe site-ul dvs. WordPress. Nu voi rescrie încă o dată una dintre aceste opțiuni în acest articol, deoarece nu există niciun punct anume în acest sens - puteți găsi cu ușurință toate aceste opțiuni pe Internet. În acest articol, ne vom uita pur și simplu la cum să creați roboți txt pentru WordPress și ce reguli minime ar trebui să existe.

Să începem cu unde ar trebui să fie localizat fișierul robots.txt și ce să scrieți în el. Acest fișier, ca și fișierul sitemap.xml, ar trebui să fie localizat la rădăcina site-ului dvs., de exemplu. ar trebui să fie disponibil la http://site/robots.txt

Încercați să contactați această adresă, înlocuind cuvântul site cu adresa site-ului dvs. web. Puteți vedea așa ceva:

Deși puteți vedea această imagine:

O situație ciudată, zici. Într-adevăr, adresa este aceeași, dar în primul caz fișierul este accesibil, în al doilea nu. Mai mult, dacă te uiți la rădăcina site-ului, nu vei găsi acolo niciun fișier robots.txt. Cum și unde se află robots.txt în WordPress?

Totul este despre o configurare simplă - este reglarea CNC. Dacă CNC este activat pe site-ul dvs., atunci veți vedea robots.txt generat dinamic de motor. În caz contrar, va fi returnată o eroare 404.

Să pornim CNC-ul în meniul Setări - Permalinks, verificând setarea Post Name. Să salvăm modificările - acum fișierul robots.txt va fi generat dinamic de motor.

După cum puteți vedea în prima figură, acest fișier folosește anumite directive care stabilesc anumite reguli, și anume, pentru a permite sau interzice indexarea a ceva la o anumită adresă. După cum ați putea ghici, directiva Disallow dezactivează indexarea. În acest caz, acesta este întregul conținut al folderului wp-admin. Ei bine, directiva Allow permite indexarea. În cazul meu, este permisă indexarea fișierului admin-ajax.php din folderul wp-admin, care este interzis mai sus.

În general, motoarele de căutare, desigur, nu au nevoie de acest fișier, nici nu îmi pot imagina din ce motive a prescris WordPress această regulă; Ei bine, da, în principiu, nu îmi pare rău

Apropo, am adăugat expresia „în cazul meu” mai sus, deoarece în cazul dvs. conținutul robots.txt poate fi deja diferit. De exemplu, folderul wp-includes poate fi interzis de la indexare.

Pe lângă directivele Disallow și Allow din robots.txt, vedem directiva User-agent, pentru care este specificat un asterisc ca valoare. Un asterisc înseamnă că următorul set de reguli se aplică tuturor motoarelor de căutare. De asemenea, puteți indica numele anumitor motoare de căutare în loc de un asterisc. Fișierul robots.txt acceptă și alte directive. Nu mă voi opri asupra lor; toate cu exemple pot fi vizualizate în consola pentru webmasteri de la Google sau Yandex. Puteți citi și informațiile de pe acest site.

Cum se creează roboți txt pentru WordPress

Deci, avem un fișier pentru roboții de căutare, dar este posibil să nu vă convină în forma sa actuală. Cum să vă creați propriul fișier. Există mai multe opțiuni aici. Să începem cu primul - crearea manuală a fișierelor. Creați un document cu text simplu în Notepad și salvați-l ca roboți cu o extensie txt. În acest fișier, notați setul de reguli necesar și pur și simplu salvați-l la rădăcina site-ului dvs. WordPress, lângă fișierul de configurare wp-config.php.

Pentru orice eventualitate, verificați dacă fișierul s-a descărcat și este accesibil accesând-l din browser. Aceasta a fost prima cale. A doua metodă este aceeași generare de fișiere dinamice, doar că acum pluginul o va face. Dacă utilizați popularul plugin SEO All in One, atunci puteți utiliza unul dintre modulele acestuia.

Robots.txt a fost creat pentru a reglementa comportamentul roboților de căutare pe site-uri, și anume unde pot merge și căuta și unde nu pot. Acum aproximativ 10 ani puterea acestui fișier era mare, toate motoarele de căutare funcționau conform regulilor sale, dar acum este mai mult ca o recomandare decât o regulă.

Dar până când este anulat, webmasterii trebuie să o facă și să o configureze corect pe baza structurii și ierarhiei site-urilor. WordPress este o temă separată, deoarece CMS-ul conține multe elemente care nu trebuie scanate și indexate. Să ne dăm seama cum să compunem corect robots.txt

Unde este fișierul roboți în WordPress?

Pe orice resursă, robots.txt ar trebui să fie în folderul rădăcină. În cazul WordPress, unde se află folderul wp-admin și altele asemenea.

Locația serverului

Dacă nu a fost creat și încărcat de administratorul site-ului, atunci implicit nu poate fi găsit pe server. Versiunea standard a WordPress nu oferă un astfel de obiect.

Cum să creați textul corect al roboților

Crearea txt-ului corect pentru roboți nu este o sarcină dificilă, este mai dificil să scrieți directivele corecte în el. Mai întâi, creați un document, deschideți Notepad și faceți clic pe Salvați ca.

Salvați documentul

Salvați documentul În fereastra următoare, setați numele roboților, lăsați extensia txt, codificarea ANSI și faceți clic pe Salvare. Obiectul va apărea în folderul în care a avut loc salvarea. În timp ce documentul este gol și nu conține nimic, să ne dăm seama exact ce directive poate suporta.

Dacă doriți, îl puteți descărca imediat pe server la rădăcină prin .

Salvarea roboților

Salvarea roboților Configurarea comenzilor

Voi evidenția patru comenzi principale:

- User-agent: arată reguli pentru diferiți roboți de căutare, fie pentru toți, fie pentru cei individuali

- Disalow: interzice accesul

- Permite: permite accesul

- Harta site-ului: adresa către harta XML

Configurații învechite și inutile:

- Gazdă: indică oglinda principală, nu mai este necesară, deoarece căutarea în sine va determina opțiunea corectă

- Crawl-delay: limitează timpul în care robotul rămâne pe pagină, acum serverele sunt puternice și nu este nevoie să vă faceți griji cu privire la performanță

- Clean-param: limitează încărcarea conținutului duplicat, îl poți înregistra, dar nu va ajuta la nimic, motorul de căutare va indexa tot ce este pe site și va lua cât mai multe pagini posibil

Exemple de instrucțiuni de lucru pentru WordPress

Cert este că robotului de căutare nu îi place directivele de interzicere și va ține cont în continuare de ceea ce are nevoie. Ar trebui să existe o interdicție a indexării obiectelor care 100% nu ar trebui să fie în căutare și în bazele de date Yandex și Google. Am plasat acest exemplu de cod de lucru în robots txt.

Agent de utilizator: * Nepermis: /wp- Disallow: /tag/ Disallow: */trackback Disallow: */page Disallow: /author/* Disallow: /template.html Disallow: /readme.html Disallow: *?replytocom Permite: */uploads Permite: *.js Permite: *.css Permite: *.png Permite: *.gif Permite: *.jpg Harta site: https://domeniul tau/sitemap.xml

Să ne uităm la text și să vedem exact ce am permis și ce am interzis:

- User-agent, pune semnul *, indicând astfel că toate motoarele de căutare trebuie să respecte regulile

- Un bloc cu Disallow interzice toate paginile tehnice și duplicatele din index. Vă rugăm să rețineți că am blocat folderele care încep cu wp-

- Blocul Allow vă permite să scanați scripturi, imagini și fișiere css, acest lucru este necesar pentru prezentarea corectă a proiectului în căutare, altfel veți obține o pantă fără înregistrare

- : arată calea către harta site-ului XML, trebuie să creați una și, de asemenea, să înlocuiți inscripția „domeniul dvs.”

Recomand să nu adăugați directivele rămase după salvare și modificări, încărcați roboții standard în rădăcina WordPress. Pentru a verifica disponibilitatea, deschide următoarea adresă https://your-domain/robots.txt, înlocuiește domeniul cu al tău, ar trebui să arate așa.

Adresă în șirul de interogare

Adresă în șirul de interogare Cum se verifică funcționarea robots.txt

Modul standard de verificare este prin serviciul webmaster Yandex. Pentru o analiză mai bună, trebuie să vă înregistrați și să instalați serviciul pe site. În partea de sus vedem roboții încărcați, faceți clic pe verifica.

Verificarea unui document în Yandex

Verificarea unui document în Yandex Mai jos va apărea un bloc cu erori dacă nu există, treceți la pasul următor dacă comanda este afișată incorect, apoi corectați-o și verificați din nou;

Nu există erori în validator

Nu există erori în validator Să verificăm dacă Yandex procesează corect comenzile, să coborâm puțin mai jos, să introduceți două adrese interzise și permise, nu uitați să faceți clic pe Verificare. În imagine vedem că instrucțiunea a funcționat, este marcat cu roșu că intrarea este interzisă, iar cu bifa verde că este permisă indexarea înregistrărilor.

Verificarea folderelor și paginilor în Yandex

Verificarea folderelor și paginilor în Yandex Am verificat, totul funcționează, să trecem la următoarea metodă - configurarea roboților folosind plugin-uri. Dacă procesul nu este clar, atunci urmăriți videoclipul nostru.

Generator de pluginuri Virtual Robots.txt

Dacă nu doriți să aveți de-a face cu o conexiune FTP, atunci un excelent generator de plugin WordPress vine în ajutor numit Virtual Robots.txt. Îl instalăm standard din panoul de administrare WordPress căutând sau descarcând arhiva, arată așa.

Cum arată Virtual Robots.txt

Cum arată Virtual Robots.txt Setări > Virtual Robots.txt, vedem o configurație familiară, dar trebuie să o înlocuim cu a noastră din articol. Copiați și lipiți, nu uitați să salvați.

Configurarea Virtual Robots.txt

Configurarea Virtual Robots.txt Roboții vor fi creați automat și vor deveni disponibili la aceeași adresă. Dacă doriți să verificați dacă este în fișierele WordPress, nu vom vedea nimic, deoarece documentul este virtual și poate fi editat doar din plugin, dar Yandex și Google îl vor vedea.

Adăugați cu Yoast SEO

Celebrul plugin Yoast SEO oferă posibilitatea de a adăuga și edita robots.txt din tabloul de bord WordPress. Mai mult, fișierul creat apare pe server (și nu virtual) și se află la rădăcina site-ului, adică după ștergere sau dezactivare, roboții rămân. Accesați Instrumente > Editor.

Editor de fișiere Yoast SEO

Editor de fișiere Yoast SEO Dacă există roboți, va fi afișat pe pagină, dacă nu, există un buton „creați”, faceți clic pe el.

Butonul Creați roboți

Butonul Creați roboți Va apărea o zonă de text, notați textul existent din configurația universală și salvați-l. Puteți verifica dacă documentul va apărea prin conexiune FTP.

Editați după modul în All in One SEO

Vechiul plugin All in One SEO poate schimba roboții txt pentru a activa funcția, mergeți la secțiunea de module și găsiți articolul cu același nume, faceți clic pe Activare;

Module în All In One SEO

Module în All In One SEO O nouă secțiune va apărea în meniul All in One SEO, intrați și vedeți funcționalitatea constructorului.

Lucrează în modulul AIOS

Lucrează în modulul AIOS - Notați numele agentului, în cazul nostru * sau lăsați-l necompletat

- Permiteți sau dezactivați indexarea

- Director sau pagină în care nu trebuie să accesați

- Rezultat

Modulul nu este convenabil; este dificil să se creeze un robots.txt valid și corect folosind acest principiu. Mai bine folosiți alte instrumente.

Configurare corectă pentru pluginul WooCommerce

Pentru a face setările corecte pentru plugin-ul magazinului online WordPress WooCommerce, adăugați aceste rânduri la restul:

Disallow: /cart/ Disallow: /checkout/ Disallow: /*add-to-cost=*

Facem același lucru și îl încărcăm pe server prin FTP sau plugin.

Concluzie

Să rezumam ce trebuie făcut pentru a ne asigura că site-ul WordPress are fișierul corect pentru motoarele de căutare:

- Creați un fișier manual sau folosind un plugin

- Notăm instrucțiunile din articol în el

- Încărcarea pe server

- Verificăm în validatorul Yandex

- Nu folosiți generatoare de roboți txt pe Internet, mișcați puțin mâinile

Îmbunătățiți-vă blogurile pe WordPress, promovați-vă și configurați corect toți parametrii, iar noi vă vom ajuta cu asta, mult succes!

De ce să creați un fișier robots.txt pentru un site găzduit WordPress și care este cel mai bun mod de a-l configura? Utilizarea necorespunzătoare a acestui fișier poate deteriora indexarea site-ului și promovarea acestuia în motoarele de căutare.

Setările corecte vor elimina paginile duplicate și vor ascunde paginile inutile din rezultatele căutării.

Cel mai simplu exemplu de fișier robots.txt pentru WordPress, care închide doar panoul de administrare:

Unde este fișierul de setări implicite pentru roboți în WP?

Programul de instalare standard WordPress nu conține un fișier roboți. Prin urmare, după instalarea CMS-ului, va trebui să-l creați singur. În articolul nostru veți găsi informații complete despre toate comenzile conținute în acest fișier. De asemenea, vă oferim un cod de lucru gata făcut pentru acest fișier - trebuie doar să îl copiați în fișierul roboților. Tot ce trebuie să faceți este să vă creați propriul fișier, să copiați codul în el și să îl adăugați în folderul rădăcină al site-ului dvs. După aceea, verificați corectitudinea acesteia pentru motoarele de căutare conform instrucțiunilor noastre.

Găzduire web virtuală pentru CMS popular:

Un exemplu de fișier robots.txt pe care îl puteți folosi pe site-ul dvs.

Puteți selecta acest cod și îl puteți lipi în site-ul dvs. WordPress, înlocuind linkurile din secțiunile Gazdă și Sitemap cu adresa site-ului dvs.

Nu permiteți: /wp-admin

Disallow: /wp-includes

Nu permiteți: /wp-content/cache

Nu permiteți: /wp-content/themes

Disallow: /trackback

Nu permite: */trackback

Nu permiteți: */*/trackback

Nu permiteți: */*/feed/*/

Nu permiteți: */feed

Nu permite: /*?*

Agent utilizator: Yandex

Nu permiteți: /wp-admin

Disallow: /wp-includes

Nu permiteți: /wp-content/plugins

Nu permiteți: /wp-content/cache

Nu permiteți: /wp-content/themes

Disallow: /trackback

Nu permite: */trackback

Nu permiteți: */*/trackback

Nu permiteți: */*/feed/*/

Nu permiteți: */feed

Nu permite: /*?*

Gazdă: http://site.ru/

Harta site-ului: http://site.ru/sitemap.xml

Fișierul robots.txt este un fișier text simplu pe care îl puteți crea în orice editor de text. Toate instrucțiunile utilizate în robots.txt conduc la unul dintre cele trei rezultate:

- Permisiune de indexare – roboții de căutare pot accesa cu crawlere tot conținutul.

- O interdicție completă a indexării - nimic din conținutul site-ului nu va fi accesat cu crawlere.

- Permisiune condiționată - sunt setate directive specifice care indică capacitatea de a scana anumite foldere și fișiere.

Există adesea dezacorduri cu privire la ceea ce ar trebui să fie introdus în fișierul robots.txt. Vă rugăm să rețineți că acest fișier nu este destinat să rezolve problemele de securitate ale site-ului web, așa că, dacă doriți să împiedicați roboții să acceseze conținut privat, va trebui să protejați cu parolă zona în care sunt stocate astfel de informații.

De obicei, fișierul robots.txt este menit să ofere îndrumări motoarelor de căutare, dar este posibil să nu urmeze aceste instrucțiuni. O versiune a fișierului robots.txt este afișată în captură de ecran.

Să ne uităm la ce funcții îndeplinește fiecare linie din acest fișier. Directiva User-agent denotă un grup de instrucțiuni destinate unui robot sau tuturor simultan. Există două opțiuni de utilizare:

- Dacă tuturor roboților li se dau aceleași instrucțiuni, este dat un asterisc (linia 1);

- dacă este specificat numele unui anumit bot, atunci condițiile se vor aplica numai acestuia (linia 15).

Dezvoltatorii Yandex observă că, dacă User-agent specifică direct robotul acestui motor de căutare, atunci aceleași instrucțiuni generale care sunt folosite pentru alți roboți de căutare (liniile 15-24) ar trebui repetate în această secțiune. În caz contrar, robotul Yandex va ține cont doar de acele comenzi care sunt scrise în mod explicit pentru el și va ignora restul.

Nu permiteți

Directiva Disallow informează roboții care directoare nu ar trebui să fie indexate. De exemplu, dacă trebuie să împiedicați motoarele de căutare să indexeze fotografiile de pe site-ul dvs., plasați fișierele cu aceste fotografii într-un singur folder și blocați accesul la acesta.

Pentru un site creat pe WordPress este obligatoriu să interziceți indexarea zonei de admin, adică a folderului wp-admin. În plus, puteți interzice indexarea categoriilor, arhivelor și etichetelor, deși atunci când utilizați pluginuri SEO pe WordPress, aceste interdicții sunt setate în setările pluginului. În exemplul de mai sus, șablonul și folderele de conținut din cache sunt, de asemenea, protejate împotriva unei posibile intrări în index.

Permite

Directiva Allow vă permite să spuneți robotului că poate vedea un fișier dintr-un folder care este interzis de alte instrucțiuni. Această directivă nu este prezentă în exemplu, deoarece Acest fișier funcționează pe principiul „ceea ce nu este interzis este permis”.

Gazdă și Harta site-ului

Directiva Gazdă raportează adresa oglinzii principale a site-ului. Comanda Sitemap este destinată oricăror roboți, marchează locația fișierului xml cu structura site-ului și facilitează indexarea paginilor de către motoarele de căutare.

Unde să încărcați fișierul robots.txt în WordPress

Dacă nu există niciun fișier robots.txt pe site, ar trebui să creați unul. Puteți folosi Notepad++ pe Windows sau TextEdit pe Mac.

- Creați un fișier text nou, notați directivele necesare și salvați-l pe computer ca robots.txt.

- Conectați-vă la serverul de găzduire prin managerul de fișiere și copiați fișierul robots.txt (2) în directorul rădăcină (1) al site-ului web.

- În bara de adrese, tastați /robots.txt imediat după numele domeniului și asigurați-vă că conținutul fișierului este afișat de browser. Dacă utilizați subdomenii, trebuie să creați robots.txt pentru fiecare subdomeniu.

Verificarea textului roboților cu Yandex și Google - fișierul funcționează corect?

Este recomandat să testați fișierul robots.txt pentru a vă asigura că funcționează exact așa cum vă așteptați din instrucțiunile introduse în el. Înainte de a analiza, asigurați-vă că site-ul este înregistrat în instrumentele webmaster oferite de motoarele de căutare Google și Yandex.

Pentru a verifica cu Yandex, accesați contul webmasterului utilizând linkul https://webmaster.yandex.ru. Selectați meniul „Tools” și submeniul „Robots.txt Analysis”.

Pentru a verifica fișierul pe Google, urmați linkul https://www.google.com/webmasters/tools. În meniul „Scanare”, selectați elementul „Instrument de verificare a fișierelor Robots.txt”.

Ambele sisteme vă permit să trimiteți un fișier robots.txt pentru verificare, după care oferă rezultate ale analizei și mesaje de eroare dacă au fost găsite.

De ce este nevoie de robots.txt pe un site WordPress?

Fișierul robots.txt este un document text obișnuit găzduit pe un server web, informează roboții de căutare despre accesul la secțiuni ale site-ului. Când utilizați acest fișier, puteți seta instrucțiuni, de exemplu, interziceți motoarele de căutare să indexeze fișierele de servicii și categoriile de site, să indicați versiunea principală a site-ului și calea către harta site-ului în format xml. Înainte ca un motor de căutare să indexeze un site, un robot, cum ar fi Googlebot sau Yandex, îl va vizita și va scana fișierul robots.txt pentru comenzi despre paginile care pot fi vizitate și salvate în rezultatele căutării.

Pentru a verifica dacă un site are un fișier robots.txt, introduceți /robots.txt în bara de adrese imediat după numele domeniului. Dacă acest fișier lipsește, roboții motoarelor de căutare au acces deplin la site-ul dvs. În același timp, rezultatele căutării pot conține link-uri către panoul de administrare și toate informațiile care ar trebui să fie ascunse persoanelor din exterior. În acest sens, există o serie de motive pentru care va trebui să utilizați fișierul robots.txt:

- Există conținut pe site pe care doriți să îl blocați pentru a nu fi afișat în motoarele de căutare, de exemplu, pagini duplicate sau rezultate de căutare interne pe site, contul personal al unui utilizator sau un coș de cumpărături.

- Doriți să ajustați accesul la site pentru roboții cunoscuți.

- Utilizați linkuri plătite sau reclame care necesită instrucțiuni speciale pentru roboți.

- Dezvoltați un site web în timp real, dar nu doriți ca motoarele de căutare să-l indexeze încă.

- Doriți să spuneți roboților de căutare unde se află fișierul de navigare a sitemapului.

Fiecare dintre aceste situații poate fi corectată în moduri diferite, dar configurarea unui fișier robots.txt va ajuta la implementarea lor pe toate simultan într-un singur loc, deoarece majoritatea webmasterilor au accesul la site necesar pentru a crea și utiliza un fișier robots.txt.